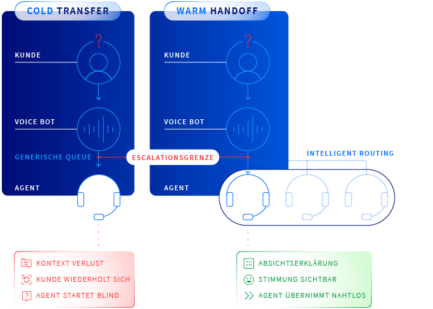

So sieht eine schlechte KI-zu-Mensch-Übergabe aus:

- Der Gesprächsverlauf verschwindet

- Der Agent bittet den Kunden, von vorn zu beginnen (oder alles zu wiederholen)

- Der Transfer wirft den Kunden in eine generische Warteschlange (noch mehr Wiederholungen)

Das passiert viel öfter, als die meisten Unternehmen zugeben möchten, aber die KI selbst ist normalerweise nicht das Problem. Die meisten KI-Sprach- oder Chatbots verstehen die Frage und können die erste Interaktion, für die sie gedacht sind, bewältigen. Der Bruch passiert am Übergabepunkt. Das ist der Moment, in dem ein Kundenanliegen das übersteigt, was vorhandene Automatisierung lösen kann, und menschliches Urteilsvermögen erfordert.

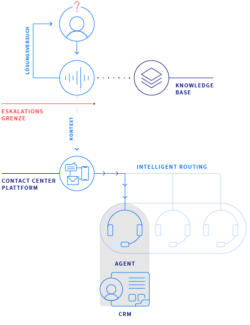

Das ist die Arbeit von Eskalationsdesign: wie Service-Teams entwickeln, was passiert, wenn KI an ihre Grenzen kommt. Es ist nicht glamourös. Aber es kann den Unterschied machen zwischen KI-Investitionen, die messbaren ROI liefern, und teuren Pilotprojekten, die verpuffen.

Was ist Eskalationsdesign im Kundenservice?

Eskalationsdesign definiert, wann ein Kunde übergeben wird, welche Informationen mit dem Kunden mitgehen und wie gut Agenten den Faden aufnehmen können, ohne etwas zu verpassen. Man kann es als Sicherheitsnetz sehen, das Automatisierung skalierbar macht: Die 80%, die Ihre KI abdeckt, funktionieren nur, wenn die 20%, die Menschen brauchen, genauso sorgfältig gestaltet sind.

Die Übergabe ist der versteckte Schwachpunkt

Die Diskussion über KI in Contact Centern konzentriert sich häufig auf Automatisierungsfähigkeiten: welchen Prozentsatz an Anfragen der Bot bearbeiten kann; wie viel schneller er Routinefragen löst; wie viele Agentenstunden er einspart. Das sind zentrale Kennzahlen, klar. Aber sie sagen nicht immer etwas über eine grundsätzlichere Reibungsquelle aus: wie Eskalationspfade gestaltet und optimiert werden.

Die Zahlen deuten darauf hin, dass das Eskalationsproblem weit verbreitet ist. Laut Cisco fehlt einem von drei Agenten der Kunden-Kontext, den es für ideale Experiences braucht. Eine Qualtrics-Studie vom Oktober 2025 fand heraus, dass fast jeder fünfte Konsument, der KI im Kundenservice nutzte, keinen Vorteil sah. Das ist eine Ausfallrate, die viermal höher ist als KI-Nutzung allgemein.

Zwei Fehlermuster tauchen immer wieder auf.

- Das Amnesie-Problem. Ein Kunde verbringt fünf Minuten damit, einem Chatbot seine Situation zu erklären. Der Bot stellt fest, dass das Anliegen menschliche Unterstützung erfordert, und startet einen Transfer. Der Agent übernimmt ohne jede Aufzeichnung des bisherigen Gesprächs. Der Kunde wiederholt alles von Anfang an. Wir kennen das alle.

- Der kalte Transfer. Die Übergabe erfolgt ohne Vorwarnung, Kontext oder Orientierung. Der Kunde landet in einer generischen Warteschlange. Wenn ein Agent endlich übernimmt, hat er keine Ahnung, warum diese Person anruft, was bereits versucht wurde oder welches Ergebnis der Kunde erwartet.

In beiden Szenarien scheitert die Übergabe. Und genau bei der Übergabe kann das Kundenvertrauen erheblich Schaden nehmen.

Was Klarna gelernt hat: Von KI-First zu eskalationsbewusst

Klarna’s KI-Einführung wurde zu einer der meistdiskutierten Case Studies in der Kundenservice-Automatisierung. Sowohl der aggressive Startansatz als auch der spätere Kurswechsel sind lehrreich.

Klarna’s Automatisierungs-Schritt:

- KI-Assistent bearbeitet 1.3M Gespräche/Monat, entspricht der Arbeit von ca. 800 FTEs

- Lösungszeit: 2 Minuten vs. 11 Minuten mit menschlichen Agenten

- 25% weniger Wiederholungsanfragen

- Kundenzufriedenheitswerte auf Augenhöhe mit menschlichen Agenten

Die Kennzahlen in den Schlagzeilen waren beeindruckend. Der Schritt schien ein Erfolg zu sein.

Dann entwickelte sich der Ansatz des Unternehmens weiter.

In den Medien räumte CEO Sebastian Siemiatkowski ein, dass das Unternehmen in seinem ursprünglichen Ansatz Kosteneinsparungen übergewichtet hatte und dass der Fokus auf Effizienz in bestimmten Szenarien zulasten der Qualität ging. Er verwies auch auf ein tiefer liegendes Problem: Die bestehende Kundenservice-Infrastruktur – IVRs, FAQs, Knowledge Bases – war von Anfang an nicht besonders stark.

Die KI wurde auf einem Fundament aufgebaut, das bereits Lücken hatte. Das machte technische Korrekturen nötig, die sich auf Eskalations-Infrastruktur konzentrierten, in die Klarna anfangs zu wenig investiert hatte. Zum Beispiel Klarna:

- Rüstete die KI auf, um Interaktionen vor der Übergabe zusammenzufassen, damit Agenten den vollständigen Kontext erhielten

- Führte Confidence Scoring ein: Wenn die KI nicht sicher war, dass sie ein Anliegen lösen kann, eskalierte sie an einen Menschen, statt zu raten und falsch zu liegen.

Das Ergebnis: KI begann, mehr Level-2-Support zu übernehmen, nicht weniger, weil die Übergaben sauberer waren und die Grenzen klarer definiert wurden.

Selbst die aggressivste KI-First-Implementierung zeigt, dass Eskalationspfade genauso viel Engineering-Rigor benötigen wie die Automatisierung selbst. Bei Klarna schwang das Pendel nicht zurück zu „Menschen machen alles“. Es bewegte sich zu einem Hybridmodell, in dem die Übergänge genauso sorgfältig gestaltet sind wie die Endpunkte.

Wie gutes Eskalationsdesign wirklich aussieht

Führende Contact-Center-Lösungen stellen heute Eskalationspfade – Kontextzusammenfassungen, intelligentes Routing, nahtlose Übergaben – in den Mittelpunkt ihrer Produktpositionierung.

Salesforce Agentforce Voice (angekündigt Okt 2025):

Salesforce’s Agentforce Voice betont, was sie „seamless human handoff“ nennen: vollständiger Gesprächsverlauf und Kontext bleiben erhalten. Eskalations-Trigger sind über Agentforce Builder konfigurierbar, und das System integriert sich mit Omni-Channel für skillsbasiertes Routing. Das bedeutet: Kunden werden an Agenten mit relevanter Expertise übergeben, nicht einfach an den nächsten verfügbaren.

Cisco Webex AI Agent:

Cisco’s Webex AI Agent verfolgt einen ähnlichen Ansatz: Context Summaries erleichtern die Übergabe von KI an menschliche Agenten; Mid-call Summary (Release in Q4 2025) liefert während Transfers sofortigen Kontext, sodass Agenten nicht kalt starten; und Wrap-up Summaries erzeugen automatisch Interaktions-Dokumentationen.

Cisco berichtete, dass Webex AI Agent die Call-Eskalationen bei einem grossen Equipment-Rental-Kunden um 85 Prozent reduzierte. Nicht, indem Eskalationen komplett verhindert wurden, sondern indem mehr Anliegen autonom gelöst wurden, weil der Eskalationspfad im Bedarfsfall verlässlich war.

Was Salesforce und Cisco über Eskalationsdesign zeigen:

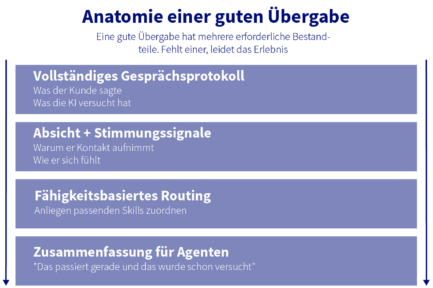

Das Muster über beide Plattformen hinweg deutet auf ein gemeinsames Set an Eskalationsdesign-Elementen hin:

- Vollständige Übertragung des Gesprächs-Transkripts: Alles, was der Kunde gesagt hat, alles, was die KI versucht hat, und jede Information, die bereits gesammelt wurde.

- Weitergabe von Sentiment- und Intent-Erkennung an den Agenten: Nicht nur, worüber gesprochen wurde, sondern wie sich der Kunde fühlte und was er wirklich erreichen möchte.

- Skillsbasiertes Routing, das Eskalationskontext berücksichtigt: Kunden werden anhand der spezifischen Art ihres Anliegens Agenten zugeordnet, nicht nur nach Warteschlangen-Verfügbarkeit.

Die Engineering-Herausforderungen, über die niemand spricht

Eskalationsdesign erfordert systemübergreifende Integration, real-time Datenfluss und bewusste UX-Entscheidungen, die die meisten Implementierungen übersehen. Das ist ein Grund, warum die Ausfallraten von KI in der Customer Experience hartnäckig hoch bleiben.

Die Statistiken zeichnen ein schwieriges Bild:

- 74 Prozent der Enterprise-CX-KI-Programme liefern nicht (E-Globalis)

- Nur jedes vierte KI-Projekt liefert den versprochenen ROI (IBM)

- 42 Prozent der Unternehmen haben die meisten KI-Initiativen aufgegeben (S&P Global)

- 40 Prozent der agentischen KI-Projekte könnten bis Ende 2027 eingestellt werden (Gartner)

Diese Zahlen spiegeln viele Fehlermodi wider, aber unserer Erfahrung nach trägt Eskalationsdesign überproportional zur Lücke zwischen Pilot-Erfolg und Enttäuschung im Produktivbetrieb bei. Diese Lücken stellen Engineering-Teams vor schwierige Aufgaben:

- CRM-Integrationslücken führen dazu, dass Agenten beim Transfer die Kundenhistorie nicht sehen

- Trennung von Knowledge Base sorgt dafür, dass Übergabe-Zusammenfassungen nicht enthalten, welche Lösungen bereits versucht wurden

- Silos in Ticketing-Systemen bedeuten, dass Case-Erstellung nach dem Transfer statt währenddessen passiert und Kontext in der Übergabe verloren geht

- Latenzprobleme, die im Chat tolerierbar sind, werden in Voice Conversations unakzeptabel

- Einschränkungen von Legacy-Systemen bedeuten, dass Transkripte unvollständig sind, wenn Calls aus bestehender IVR-Infrastruktur weitergeleitet werden.

Die Commonwealth Bank of Australia Story

Commonwealth Bank of Australia hat diese Lektion im August 2025 öffentlich gelernt. Australiens grösste Bank rollte einen KI-Voicebot aus, um Routineanfragen im Kundenservice zu bearbeiten, und behauptete, sie habe das Anrufvolumen um 2.000 pro Woche reduziert.

Auf Basis dieser Zahlen strich die Bank 45 Customer-Service-Rollen.

Die Finance Sector Union stellte die Daten infrage. Ihre Mitglieder berichteten das Gegenteil: Die Call-Volumes stiegen tatsächlich. Mitarbeitende erhielten Überstunden. Teamleiter wurden an die Telefone geholt, um den Überlauf zu bewältigen. Der Bot erzeugte Eskalationen, statt sie zu reduzieren.

Innerhalb weniger Wochen machte CBA die Entlassungen rückgängig und entschuldigte sich öffentlich. Ein Sprecher räumte ein, die Bank habe „nicht alle relevanten geschäftlichen Aspekte ausreichend berücksichtigt“.

Die Lektion ist lehrreich. Automatisierungs-Kennzahlen können auf dem Papier gut aussehen, während Eskalationspfade im Hintergrund leise scheitern. CBA’s Bot hat einfache Anfragen vielleicht effektiv bearbeitet, aber ohne funktionierende Übergaben für alles Komplexe stieg die menschliche Arbeitslast statt zu sinken. Die KI funktionierte. Das System drumherum nicht.

Gartner’s Prognose und die operative Realität

Die Entwicklung von KI im Kundenservice zeigt in Richtung zunehmender Autonomie. Gartner prognostiziert, dass agentische KI bis 2029 80 Prozent häufiger Kundenservice-Anliegen ohne menschliches Eingreifen lösen wird und damit die operativen Kosten um 30 Prozent senkt. Bis 2028 erwarten sie, dass 70 Prozent der Customer Journeys mit Conversational Assistants von Drittanbietern beginnen und enden.

77 percent of service leadersDer Druck, in diese Richtung zu gehen, ist bereits akut. Eine Gartner-Umfrage von April–Mai 2025 ergab, dass 77 Prozent der Service-Leader Druck von Executives spüren, KI einzuführen. 85 Prozent der Verantwortlichen im Kundenservice planen, 2025 Customer-facing Conversational GenAI zu erkunden oder zu pilotieren.

Aber Gartner’s Implementierungs-Empfehlungen fokussieren deutlich auf Grenzen, nicht nur auf Fähigkeiten. Dazu gehören das Definieren von KI-Interaktionsrichtlinien, die Eskalation explizit adressieren, sowie das Anpassen von Service-Modellen, um KI-getriebenes Volumen zu bewältigen, während dynamisches Routing implementiert wird, das zwischen menschlichen und KI-Interaktionen unterscheidet.

Die Frage nach dem Implementierungs-Partner

Die Lücke zwischen KI-Fähigkeit und KI-Erfolg ist die Implementierung. Das gilt besonders für Eskalationspfade, die tiefes Plattform-Know-how und systemübergreifende Integration erfordern – über Contact-Center-Infrastruktur, CRM, Knowledge Management und Workforce Routing hinweg.

Was funktionierende Implementierungen von nicht funktionierenden trennt, hängt oft davon ab, ob das Team, das das System baut, durchdacht hat, was passiert, wenn KI etwas nicht lösen kann.

Bei der Bewertung eines Implementierungs-Partners zählen mehrere Faktoren mehr als Zertifizierungs-Badges eines Vendors oder die Anzahl an Case Studies:

- Erfahrung mit Telefonie/Contact Center und CRM-Integration: nicht nur das eine oder das andere, sondern die Schnittstelle, an der Eskalation tatsächlich passiert.

- Verständnis für Konfiguration und Testing von Eskalations-Schwellen: zu wissen, wo die Confidence Boundaries gesetzt werden müssen und wie man sie anhand realer Interaktionsdaten tuned.

- Nachweisliche Erfahrung mit Kontexttransfer über Systeme hinweg: über die Legacy-Infrastruktur, die die meisten Enterprises tatsächlich haben.

- Fähigkeit, „Warm Welcome“-Übergabeerlebnisse zu gestalten: Der Agent begrüsst den Kunden namentlich, erkennt das Anliegen an und macht dort weiter, wo die KI aufgehört hat, statt bei null zu starten.

Die Fragen, die man stellen sollte, sind konkret:

- Wie stellen Sie Kontext-Erhalt sicher, wenn Calls aus Legacy-IVR transferiert werden?

- Wie gehen Sie nach dem Go-live bei der Feinabstimmung von Eskalations-Schwellen vor?

- Wie testen Sie Übergabe-Szenarien vor dem Go-live?

- Welche Sichtbarkeit haben Agenten in den KI-Gesprächsverlauf?

Die Antworten zeigen, ob ein Partner diese Probleme in der Produktion wirklich gelöst hat oder Ihre Implementierung erst lernt.

Eskalationsdesign ist nicht der spannendste Teil einer KI-Einführung. Es macht keine Schlagzeilen (ausser wenn es scheitert) und beeindruckt Boards nicht mit futuristischen Demos. Aber es ist zunehmend der Ort, an dem Contact Center KI in der Praxis gewinnt oder verliert.

Organisationen, die das richtig machen, sind nicht diejenigen mit der ausgefeiltesten Automatisierung. Es sind diejenigen, die mit gleicher Strenge gestalten, was an den Grenzen passiert – also dann, wenn KI an ihre Grenzen kommt und ein Mensch übernehmen muss, ohne dass der Kunde die Naht bemerkt.

Eskalationsdesign richtig machen

Bucher + Suter spezialisiert sich auf das Engineering, das KI im Produktivbetrieb funktionieren lässt: Cisco- und Salesforce-Integration, Konfiguration von Eskalations-Schwellen, Kontexttransfer über Legacy-Systeme hinweg und „Warm Welcome“-Übergabeerlebnisse, die Kunden davon abhalten, von vorn zu beginnen. Kontaktieren Sie uns noch heute.